복잡함은 지우고, 단순함만 남기다

Backend.AI는 AI 개발자와 데이터 과학자가 하드웨어 복잡성에서 벗어나 본질적인 작업에 집중할 수 있도록 돕는 오픈소스 기반의 AI 인프라 운영체제입니다. 범용 GPU부터 데이터센터용 AI 가속기, NPU, TPU를 비롯한 ASIC까지 총 11종 이상의 이기종 가속 하드웨어를 지원하며, 다양한 고성능 스토리지와도 완벽하게 연결할 수 있습니다.

딥러닝 학습부터 추론 서비스 배포까지, ‘AI Infra OS’ Backend.AI와 함께 여러분의 AI/HPC 인프라 잠재력을 최대로 이끌어내세요.

인프라가 제약이 아닌 경쟁력이 될 수 있도록

Backend.AI는 온프레미스, 클라우드, 하이브리드를 가리지 않고 모든 인프라 환경에서 안정적인 AI 운영을 보장합니다. 심지어 인터넷이 연결되지 않은 폐쇄망 클러스터일지라도 전혀 걱정할 필요가 없습니다. Backend.AI는 어떤 환경일지라도 고객의 AI 비즈니스를 지원할 준비가 되어 있으니까요.

11종 이상의 AI 가속기를 지원하는 벤더 중립적 플랫폼

Backend.AI는 NVIDIA Blackwell 등 최신의 GPU는 물론 Intel Gaudi, AMD Instinct, Rebellions ATOM+, Furiosa RNGD 등 11종 이상의 AI 가속기를 지원합니다. 워크로드 특성과 예산에 맞춰 가속기를 자유롭게 선택하고, 이기종 가속기를 동시에 운영할 수 있습니다. 새로운 종류의 가속기 도입도 걱정 마세요. Backend.AI로 모든 가속기를 일관되게 관리하고, 추상화 계층과 플러그인 구조를 통해 새로운 가속기도 빠르게 통합할 수 있습니다.

DGX 시스템을 위한 NVIDIA DGX™-Ready 소프트웨어

Backend.AI는 NVIDIA DGX™-Ready 소프트웨어 인증을 통해 DGX의 최대 성능을 이끌어내도록 설계되었습니다. Backend.AI는 NVIDIA의 컨테이너 런타임을 기반으로 엔터프라이즈 운영에 필요한 기능들을 한 단계 확장합니다. 다중 사용자를 위한 GPU 공유 및 세밀한 할당 기능을 통해 여러 팀과 프로젝트가 자원을 효율적으로 나눠 쓸 수 있으며, CPU/GPU 토폴로지를 고려한 지능형 스케줄링으로 DGX 클러스터를 보다 안정적이고 일관된 방식으로 운영할 수 있습니다.

자체 개발 CUDA 가상화 계층 컨테이너 수준 GPU 가상화

Backend.AI의 자체 개발 CUDA 가상화 계층은 GPU를 컨테이너 단위로 자유롭게 나누고 합칠 수 있게 해줍니다. 하나의 GPU를 여러 사용자에게 나눠주거나, 반대로 여러 GPU를 묶어 하나의 대규모 작업에 할당하는 것도 가능합니다. 교육이나 추론처럼 가벼운 워크로드에는 GPU를 쪼개 쓰고, 모델 훈련처럼 큰 작업에는 여러 GPU를 한꺼번에 쓸 수 있어 자원 낭비 없이 효율적으로 운영할 수 있습니다. 래블업의 국제 특허 기술로 구현된 컨테이너 수준 GPU 분할가상화 기술은 AI와 HPC 환경에서 GPU를 가장 똑똑하게 쓸 수 있도록 돕습니다.

고성능 스토리지와 Backend.AI의 완벽한 통합

Backend.AI는 AI / HPC를 고려하여 설계된 여러 고성능 스토리지와 쉽게 연동할 수 있습니다. 스토리지 벤더를 고려한 맞춤 설정을 통해 워크로드에 맞는 성능을 안정적으로 이끌어내며, 스토리지의 모든 가능성을 활용할 수 있도록 최적화되어 있습니다. 병렬 파일 시스템의 높은 처리량, 분산 스토리지의 확장성, 저지연성 등 스토리지 솔루션별 강점을 바탕으로 대규모 학습 데이터 로딩부터 체크포인트 저장, 결과 보관까지 효율적으로 운영할 수 있습니다.

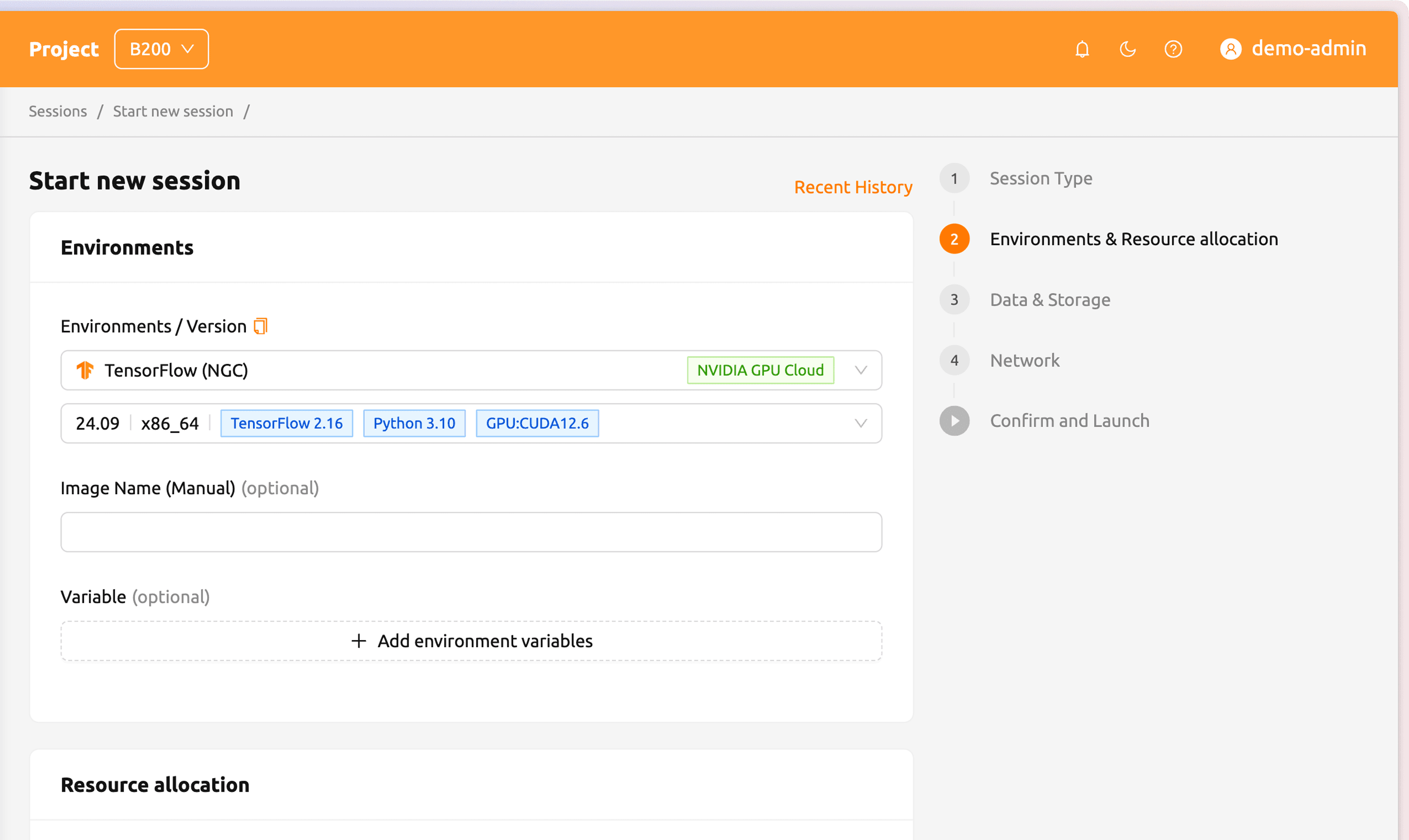

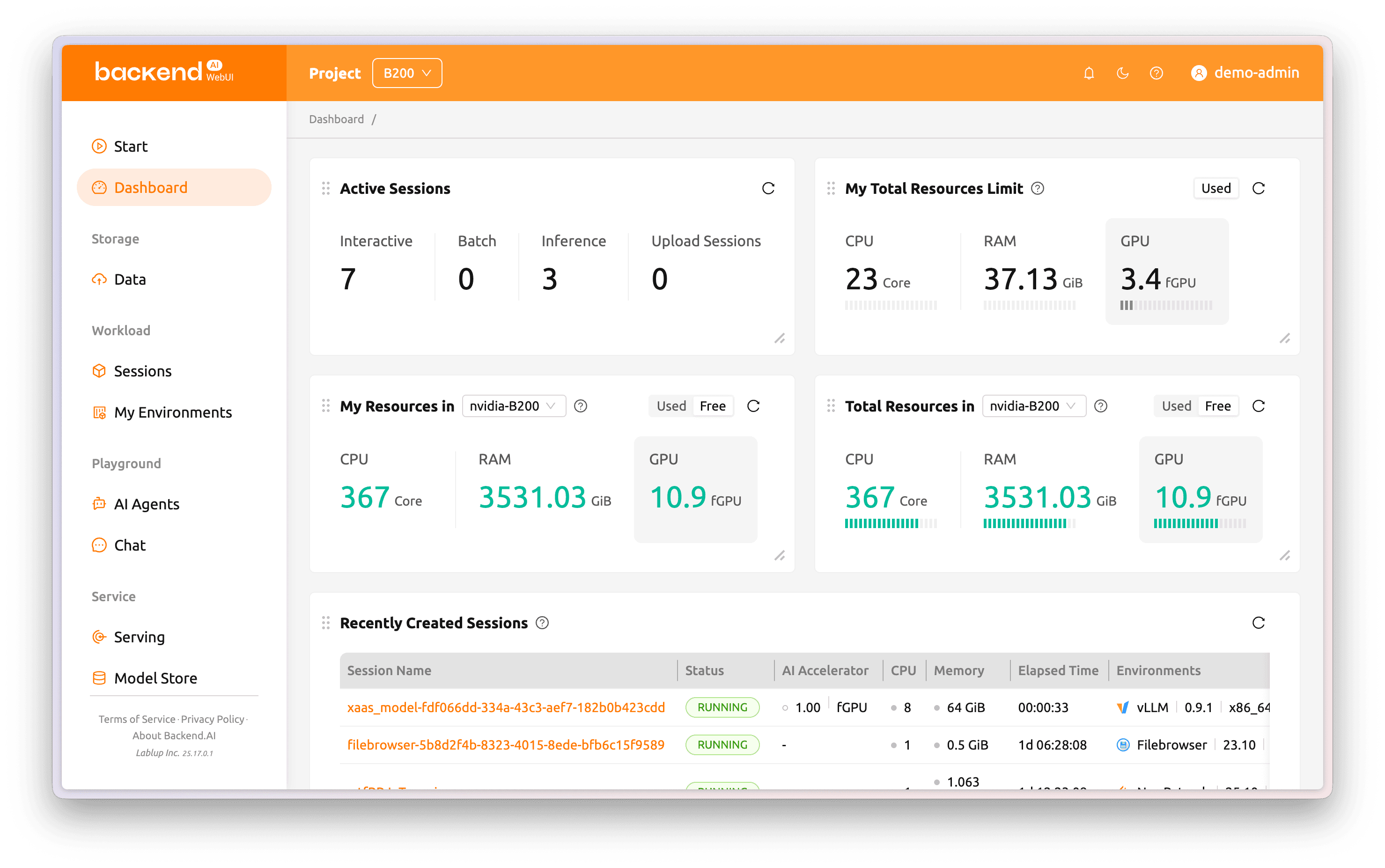

사용자 친화적 WebUI를 통한 손쉬운 인프라 관리 경험

보기 편하고 사용하기 편한 Backend.AI WebUI를 통해 클러스터의 모든 것을 모니터링하고, 제어할 수 있습니다. GPU, CPU, 메모리 사용량과 실행 중인 세션을 실시간으로 한눈에 볼 수 있고, 세션을 제어하고 리소스 할당량을 바꾸는 것도 몇 번의 클릭으로 가능합니다. 사용자, 프로젝트, 테넌트별로 권한과 쿼타를 설정할 수 있어 복잡한 인프라 정책도 간편하게 관리할 수 있어, 개발자와 연구자는 인프라 설정에 시간을 쓰지 않고 바로 실험과 서비스에 집중할 수 있습니다.